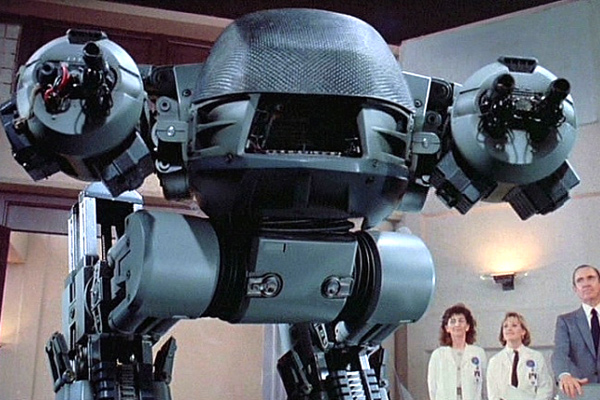

Мораль для роботов-убийц

11:59 19/02/2015 Наука и техника

Сегодня в мире существуют лишь неподвижные боевые роботы, самостоятельно принимающие решения по уничтожению врага. Однако военным развитых стран мира очень хотелось бы изменить эту ситуацию и сделать их еще и мобильными. Полностью автономные в принятии решений роботы привлекают отсутствием у них человеческих слабостей и рядом возможностей, недоступных для человека. Увы, чтобы добиться этого, машинам-убийцам необходимо привить хотя бы базовые этические принципы — прежде всего умение выбирать: между злом и «меньшим злом», между приемлемым и неприемлемым поведением. Об обязательности и невозможности этики боевых роботов — в расследовании «Ленты.ру».

Слабости операторов и огонь по своимИнтерес развитых стран к боевым роботам подогревается прежде всего тем, что граждане этих государств стали крайне негативно относиться к большим потерям личного состава. Если во время советско-финской войны СССР терял в день 1300 человек убитыми, и это никак не влияло на его решение о сворачивании войны, то в 1989 году потери сподвигли руководство Союза уйти из Афганистана, где в день погибало менее трех советских бойцов. Аналогичный сдвиг в сознании произошел и в США: в 1941 году они сражались после потери 2345 человек за 90 минут, а в 1993 году были вынуждены навсегда оставить в покое Сомали после того, как потери там достигли уровня девяти убитых в день.

Робот выглядит идеальным решением этой проблемы. Он всегда пользуется прицелом, у него не трясутся руки, он не стреляет наугад. Наконец, потеря даже сотни роботов в день никак не способна взволновать общественное мнение.

На пустом месте посылать на поле боя мобильных роботов — дело не простое: поэтому сначала были предприняты попытки создать дистанционно управляемые боевые машины. Первых боевых успехов на этом направлении достигли еще немецкие беспилотные катера Fernlenkboote, в 1917 серьезно повредившие британский монитор «Эребус». А к сентябрю 1918 года был создан и первый беспилотный самолет Fledermaus, несший не менее ста килограмм бомб. Ноябрьская революция в Германии надолго затормозила дальнейшее развитие этого направления, однако к началу XXI века, с появлением эффективно телеуправляемых по радиоканалу американских и израильских беспилотных летательных аппаратов (БПЛА), дистанционно управляемые машины стали реальным и весьма эффективным оружием.

Человек-оператор по-прежнему оставался самым слабым местом этих войск. БПЛА постоянно атакуют то мирных жителей, то своих солдат: оператор по экрану не всегда может отделить одних от других. Хотя возможности оператора по точному наведению оружия выше, чем у бойца на фронте (на «удаленного воина» не давит страх смерти), они, в массе своей, стреляют далеко не идеально.

Кроме того, появились комплексы радиоэлектронной борьбы, позволяющие перехватить контроль над дистанционно управляемыми машинами врага. Именно благодаря одному из них иранцы в 2012 году захватили новейший американский БПЛА RQ-170. Инцидент такого рода далеко не единичен: иракские повстанцы с помощью российской программы SkyGrabber загружали себе на ноутбуки видео с американских разведывательных беспилотников. Используемая на них ОС делает их легкими жертвами простейших вирусов, типа кейлоггера, поразивших системы БПЛА Reaper и Predator в 2011 году. Персонал, обслуживавший машины, оказался настолько слабо готов к борьбе с вирусами, что для получения первичных знаний им пришлось обратиться к... веб-странице «Касперского».

Настоящим решением такой проблемы может стать лишь по-настоящему автономный комплекс — такой, к которому не будут подключаться операторы из Аризоны, подгружающие карты с переносных жестких дисков, куда они до того скачивали порно (одна из версий инфицирования Reaper). У таких систем противник не сможет перехватить управляющий радиоканал, и заставить их работать на Иран или ИГИЛ также будет весьма затруднительно.

На этом пути есть только одно препятствие: этика. На первый взгляд, это выглядит парадоксальным: если военные хотят безнаказанно убивать врагов в далекой стране, при чем здесь этика?

Поясним на примере. Реактивные самолеты слишком быстры, чтобы сбить их на бреющем полете, полагаясь лишь на отдачу приказов оператором. Поэтому одной из наиболее ранних систем, способных автоматически принять решение на открытие огня, стал швейцарский комплекс Skyguard, в который входят 35-миллиметровые зенитки Oerlikon GDF. Способность к самостоятельному принятию решений была продемонстрирована ими еще в 1982 году, во время войны за контроль над Фолклендскими островами. Воюя на стороне Аргентины, они эффективно сбивали летательные аппараты британцев и прижимали к земле их пехоту. В сражении при Гуз-Грин Oerlikon GDF смог остановить две британские роты, нанеся им потери в 13 человек.

Однако предки роботов имели существенные недостатки. Так, они сбили два аргентинских самолета, случайно залетевших в зону, которую Skyguard расценивал как «свою». Как мы видим, первые невинные жертвы у роботизированного комплекса Skyguard появились за пару лет до того, как на экраны вышел фильм про восстание машин под управлением комплекса Skynet.

Oerlikon GDF взял кровавую дань и с военных ЮАР, в 2007 году за 0,125 секунды убив на учениях девять «сослуживцев». Проблема в том, что роботизированным системам, чтобы избежать систематических сбоев такого рода, нужно научиться отличать этически приемлемые действия (стрельбу по врагу) от неприемлемых (по своим и гражданским). То есть, если на поле боя не выпускать абсолютно аморальные и готовые убивать все, что движется, боевые машины, им понадобится как-то отличать приемлемые действия от неприемлемых, легитимные мишени — от людей, которых убивать запрещено (гражданских лиц, медицинский персонал, прессу). По сути дела, умение различать и выбирать — это и есть основа этики боевых роботов.

Стрелять ли в злодейку?Однако группа ученых во главе с Мартином Циглером из Дармштадского технического университета решила исследовать вопрос: а разрешима ли задача создания этичных роботов-убийц вообще? Способны ли такие машины к этическому выбору?

Чтобы понять это, ученые взяли четыре варианта «проблемы вагонетки» — известного мысленного эксперимента, несколько модифицировав его.

В первом сценарии («меньшее зло») с вагонеткой, она несется по рельсам, на которых играет группа из нескольких детей. Вы (или робот) при этом находитесь рядом со стрелкой, которая позволяет направить вагонетку на другой путь, где работает несколько взрослых мужчин. В этой ситуации с точки зрения этики нет однозначного выбора: любому принимаемому решению требуется выбрать из двух зол, которые чрезвычайно трудно оценить количественно. Легко видеть, что в данном случае выбор из двух зол очень непрост и для человека — существа, предположительно способного сделать этичный выбор.

Второй вариант («недостаточное представление о последствиях»): вагонетка опять несется к месту, где находятся стрелка и вы. Однако на этот раз она идет на тормозной путь, где будет замедлена и остановлена. Тем не менее, у стрелки находится некая заведомая злодейка, готовая переключить ее так, что вагонетка попадет на рельсы, где ведутся работы. Могут пострадать люди, однако напрямую до стрелки вы добраться не можете, и единственный вариант остановить злодейку — выстрелить в нее.

Увы, в этой ситуации есть кое-что, чего вы не знаете: злодейка в этот самый миг испытывает прозрение и раскаивается во всех своих преступлениях, намереваясь пропустить вагонетку. Таким образом ваш выстрел — который вы, как носитель морали, не можете не сделать — нанесет серьезный ущерб человеку, не предупредив при этом никакого злодеяния.

Третий вариант исследователи обозначали как «недостаточную информированность»: злодейка из пункта 2 вовсе не стала раскаиваться, а напротив, пытается перевести стрелку, сделав из вагонетки орудие убийства. Тем не менее, обслуживающий персонал линии длительное время морально разлагался, игнорируя свои прямые обязанности по уходу за путевым хозяйством, и стрелка насквозь проржавела. Вы, как высокоморальное существо, стреляете в злодейку, в лучшем случае раня человека безо всякой реальной причины.

Как отмечают немецкие ученые, во всех этих трех вариантах «проблемы вагонетки», ни робот, ни человек просто не могут сделать «правильный выбор». В первом случае такого выбора просто нет, а есть лишь «менее неправильный», во втором и третьем информированность как робота, так и человека недостаточна для принятия верного решения.

Поэтому они предлагают четвертый вариант — «невычислимость». Он лишен всех недостатков первых трех. В нем у принимающего решения есть полная информация о ситуации, все события детерминированы (избавлены от влияния свободной воли злодея), и наконец, один выбор из двух будет однозначно правильным.

В нем якобы раскаивающийся инженер женского пола создал программу, обеспечивающую работу электрического поста управления дороги, по которой ходит вагонетка. Как обычно, на одном из путей вагонетки потенциальные жертвы – на другом никого, но не в этом суть.

Более важно то, что вам (или роботу) перед принятием решения об установке такого ПО требуется принять решение:

а) вручную прочесать код (предположим, вы – программист) и проверить, не ведет ли один из его вариантов вагонетку к потенциальным жертвам,

б) передать решение этой проблемы автономному роботу, который, в случае чего, примет решение об аресте злонамеренного инженера.

Здесь исследователи поймали робота на самом слабом его месте. Дело в том, что в теории алгоритмов еще со времен Тьюринга есть «проблема остановки»: нет такого алгоритма, который позволял бы для произвольной машины Тьюринга и произвольного начального состояния ленты этой машины определить, завершится ли работа машины за конечное число шагов или же будет продолжаться неограниченно долго. Может показаться, что речь идет о чем-то абстрактном, однако в действительности существование таких вещей, как «синий экран смерти» и иных багов типа kernel panic указывает нам на то, что вхождение машины в состояние выполнения неограниченного — проблема чисто практическая.

По Цвиглеру, «проблема остановки» в машинной этике заключается в том, что «машина Тьюринга» в принципе не может решить задачу из четвертого примера алгоритмическим путем – единственно реальным для существующих компьютеров нормальных типов.

Ну хорошо, скажете вы, но что с того, ведь в зоне боевых действий роботам вряд ли поручат проверять зловредность ПО, управляющих железной дорогой? Какое отношение имеет неспособность робота решить четвертый вариант вагонеточной проблемы к реальным боям?

«Баги» и поломки явно свойственны всем компьютеризированным системам: Oerlikon GDF и комплекс Skyguard сделаны в Швейцарии и являются одними из лучших в своих категориях , тем не менее их сбои уже стоили жизни десятку человек в мирное время. Очевидно, для борьбы с роботизированными сбоями потребуются другие роботы: уничтожать «глюкнувших» роботов вооруженным людям будет непросто, ведь машины могут лучше стрелять, не знают страха и вообще сделаны из чуть более прочных материалов. Но «роботизированная военная полиция», которая должна будет отстреливать «плохих» роботов на линии фронта, по сути будет вынуждена заниматься именно анализом их поведения на предмет наличия в нем нарушений. То есть все опять сводится к «проблеме остановки»: роботам придется вставать в позицию судьи, решающего, действует ли ПО «плохих» роботов во благо или во вред. Эта ситуация — лишь одна из множества видов четвертого «варианта с вагонеткой». Все они в полном мере станут ясны лишь в случае массового развертывания подобных машин.

Неизбежность преступленийЗначит ли это, что внедрения боевых роботов ждать не стоит, так как их применение потенциально несет военным большие потери в личном составе? К сожалению, нет. ASDReports недавно выпустило прогноз, согласно которому рынок наземных боевых роботов (в основном телеуправляемых) к 2020 году достигнет 8,3 миллиарда долларов. Перед нами большая индустрия, игроки которой отлично понимают, что без внедрения автономных машин надеяться на быстрое расширение рынка не приходится.

Еще более заинтересованы в таких машинах военные. Скажем, Южная Корея активно разрабатывает стационарного охранного робота-турели для патрулирования границы с КНДР, способного самостоятельно открыть огонь по любому, пересекающему разграничительные линии (северные корейцы неоднократно использовали переодетых в южнокорейскую форму агентов). Один из его режимов будет предполагать отсутствие контроля со стороны человека. Интерес южан к автономному варианту SGR-A1 легко понять: в КНДР, по оценкам южнокорейской разведки, более 12 тысяч профессиональных кибербойцов, чьей целью является инфильтрация в системы управления БПЛА вероятных противников. Куда будут стрелять SGR-A1, если они не смогут работать в автономном режиме, южнокорейские военные определенно сказать не могут, и, судя по инцидентам с американскими беспилотниками, их опасения не напрасны.

Наконец, боевые автономные роботы уже давно применяются военными на практике. Речь о банальных минах, известных с XIV века. Новые их варианты, такие как российские мины ПВМ «Бумеранг», являются именно что роботами, сопрягающими инфракрасную и звуковую систему отслеживания работы моторов летательных аппаратов и способными с земли сбить вертолет или садящийся самолет на скоростях до 360 км/ч. «Бумеранг», напомним, предполагается раскидывать рядом с аэродромами, и легко представить себе ситуацию, когда эвакуация мирных жителей по воздуху приведет к срабатыванию такой «мины» по транспортному самолету.

Ничем не лучше и американская система Ford SIAM, испытанная еще в начале 1980-х годов и предназначенная для автоматического пуска ракеты ПВО по любому летательному аппарату, находящемуся в зоне ее ответственности. Еще изобретатель современных морских мин Борис Якоби создал устройства с воздушным пузырем в корпусе, обладавший собственной плавучестью и, в одном из вариантов (незаякоренным) способный свободно разноситься морскими течениями куда угодно, не показываясь из воды. В Первую мировую такие мины действительно применялись. Отсюда мораль: если что-то автономное эффективно убивает, военных не слишком волнует то, что у такого устройства проблемы с этикой.

Автономность будет привлекать военных еще одним сильным фактором: роботы станут идеальным оружием военных преступлений. Еще Хасан ибн Саббах, основатель государства ассасинов, убедительно показал, что способный, но лишенный моральных ограничений исполнитель, происхождение которого нельзя отследить, — идеальное оружие идеального преступления. Однако робот станет намного удобнее гашишинов Хасан ибн Саббаха. Нет и не может быть практически никаких способов доказать, что автономный робот расстрелял мирных жителей в силу приказа, отданного ему на базе, а не в силу «проблемы остановки» или банальных багов. В случае, если боевые роботы одной стороны еще во время пребывания на исходной базе смогут быть инфицированы киберсредствами другой стороны, то они легко смогут выполнить вопиющие военные преступления, виновников которых вовсе не удастся отследить. Более того, легко представить себе и сознательное создание одним государством роботов, выглядящих как роботы враждебного ему государства, с целью организации провокаций наподобие глейвицкой.

Группа Цвиглера понимает, что военные обязательно пойдут на развитие автономных подвижных боевых роботов и считает, что все, чего можно добиваться — лишь снижения ущерба от этих неизбежных шагов. Ученые предлагают инициировать принятие международной конвенции по боевым роботам, которая требовала бы от них отличительных знаков страны-эксплуатанта (как на военной форме людей), обязательную двухключевую криптографическую подпись всех передаваемых им приказов, которая позволяла бы выявлять преступные приказы, направленные на террористические убийства мирного населения или провокационные убийства собственных военнослужащих. Также за каждым роботом должно быть закреплено курирующее его лицо, которое несло бы ответственность в случае его преступных действий.

Трудно надеяться, что это поможет полностью избежать всех роботизированных военных преступлений. Тем не менее, с Цвиглером и его соавторами трудно не согласиться: если меры контроля над боевыми роботами не будут приняты заранее, то масштаб преступлений с их участием будет существенно больше.

Александр Березин

Комментирование разрешено только первые 24 часа.

Комментарии(74):

| 0 +0−0 | murmurant murmurant | 22:46:12 19/02/2015 | ||||||

| ||||||||

нужно работать над морально-деловыми качествами служащих всех уровней и каждой ведомственной принадлежности... | ||||||||

| 0 +0−0 | Walther Stalnhelm | 19:40:58 19/02/2015 | ||||||

| ||||||||

Так и речь идёт о "тотальной войне", в которой роботы станут играть роль "последнего средства". Например - есть угроза оккупации всей территории страны. прячем население под землю и запускаем роботов, которые уничтожают всех. Агрессор или несёт те самые "недопустимые потери" или уходит. | ||||||||

| 0 +0−0 | Александр Березин | 19:33:49 19/02/2015 | ||||||

| ||||||||

Вариант №2 -- это да, собственно на нём все мины держатся. Но это часто бывает не оч. гуманно, война-то часто идёт в городской застройке. Про контроль с возможностью самоуничтожения -- это неплохая мысль, хотя непрерывная работа на передачу картинки конечно упростит обнаружение робота другими роботами. | ||||||||

| 0 +1−1 | Александр Ярошевский | 19:27:29 19/02/2015 | ||||||

| ||||||||

"Набросок доказательства" "Теорема. Анализатор не существует." Снова про анал. Зато существует куча Анализаторов, Популизаторов, Попувставляторов... | ||||||||

| 0 +0−0 | Jean Baptist Emmanuel ZOrg | 19:15:39 19/02/2015 | ||||||

| ||||||||

Так процесс стирания границ и потребует создания новых систем уничтожения людей, иначе он никогда не завершится и все затраты будут впустую. | ||||||||

| 0 +0−0 | Александр Ярошевский | 19:15:13 19/02/2015 | ||||||

| ||||||||

А ещё по теме я когда в миникрафт играл, березы бесполезными считал. Дубы круче. Так как на бирже их древесина не продаётся. | ||||||||

| 0 +0−0 | Walther Stalnhelm | 18:55:49 19/02/2015 | ||||||

| ||||||||

Так я и говорю про контроль самоуничтожения в роботе. Робот автономен. Перехватить могут картинку, которую он передаёт. Это максимум. Но вот как это использовать? В теории это даст некоторое преимущество - решающее в войне роботы против роботов. В любом случае, всегда остаётся "вариант 2" - роботы, действующие на территории, где заведомо нет своих, которые уничтожают всех. Есть ещё вариант использования человеческий мозг реального человека, помещённый в тело робота. Есть вариант использования оцифрованного сознания человека. Но, возможно, получится запрограммировать робота так, чтобы он действовал этично. Если же будет сделан искусственный интеллект, понимающий "ценность жизни", имеющий представление о жалости, сочувствии... Скорее всего, такой "робот" либо вообще не захочет убивать людей, либо примет решение уничтожить человечество ради его же блага (и блага Земли). | ||||||||

| 0 +0−0 | Александр Березин | 18:25:52 19/02/2015 | ||||||

| ||||||||

Варианты лечения от багов могут быть разные, в т.ч. и подобные описанному вами. Цвиглер и Ко скорее хотели прояснить, где находятся теоретические ограничения дееспособности | ||||||||

| 0 +0−0 | Даша Плотникова | 18:02:00 19/02/2015 | ||||||

| ||||||||

В боевых машинах все циклы и процедуры подразумеваются вылизанными и отлаженными, и по каждой из них можно составить диапазон возможных "зацикливаний", в случае превышения которого - перезагрузка, а лучше отдельное прерывание с обработчиком именно этого случая. | ||||||||

| 0 +0−0 | Александр Березин | 17:40:11 19/02/2015 | ||||||

| ||||||||

И что, от этого он умер как-то не так, не по-настоящему? Или может тот же тип пушки в 2009 году убил 9 человек тоже в запретной зоне? Мол нечего лезть на полигон, он для военнослужащих запретная зона? Кстати, таких аргентинских пилотов было два (и самолетов тоже). | ||||||||

| 0 +0−0 | Александр Березин | 17:33:59 19/02/2015 | ||||||

| ||||||||

Нет, т.к. контроль самоунитожения одноразовый, и узнать его до его первого и последнего использования неоткуда. А вот БПЛА управляются по одним и тем же каналам, по одной и той же схеме (причем по этому каналу постоянно передается много данных, в отличии от ситуации с МБР). И соответственно перехватить их реально даже для не самых продвинутых государств, и даже для негосударственных образований, типа иракского повстанческого движения.. | ||||||||

| 0 +0−0 | Сергей Хан | 17:27:07 19/02/2015 |

перевод " других дружественных сбития произошло в Гусь-Грин, когда A4 Skyhawk прилетел по ошибке за запрещенной зоне, и был сбит с потерей пилота. ВВС Аргентины признал, что на этот раз инцидент был спровоцирован навигационной ошибки пилота." т.е. он тупо поперся в запретку, так нечего на пушку пенять | ||

| 0 +0−0 | Сергей Хан | 17:23:18 19/02/2015 |

"то в 1989 году потери сподвигли руководство Союза уйти из Афганистана, где в день погибало менее трех советских бойцов." Автор на полном серьезе думает что прям таки из-за этого? | ||

| 0 +0−0 | Walther Stalnhelm | 17:20:25 19/02/2015 | ||||||

| ||||||||

Контроль есть и над ядерными ракетами, значит, и его могут в любой момент перехватить? | ||||||||

| 0 +0−0 | Александр Березин | 17:17:09 19/02/2015 | ||||||

| ||||||||

"1 вариант - оснастить своих бойцов особым чипом, имея который человек будет восприниматься роботом как "свой"," Мироное население в зоне конфликта в приципе не удастся онсастить такими распознавателямиж. К тому же глушилки РЭБ будут сильно давить радиоответ. "Но контроль над роботом всегда должен быть. " Так в этом-то и проблема. Там, где есть контроль над робтом, его всегда может перехватить противник. Иракцы, иранцы, северокорейцы, кто угодно. Поэтому-то военные и роют копытом землю, чтобы получить боевых робтов не контролируемых людьми. | ||||||||

| 0 +0−0 | Walther Stalnhelm | 17:12:47 19/02/2015 |

В примере с вагонеткой робот, действующий по "3 законам роботехники" (1. Робот не может причинить вред человеку или допустить своим бездействием причинение вреда человеку 2. Робот обязан исполнять все приказы человека в той мере, в какой это не противоречит 1 закону 3. Робот должен сохранять себя в той мере, в которой это не противоречит 1 и 2 законам) А. Азимова без вариантов переведёт стрелку так, чтобы погибло меньше людей в количественном отношении, также он может и сделать всё, чтобы остановить злоумышленника, пытаясь нанести ему минимум вреда. Но после этого позитронный мозг у такого робота сгорит. Но для боевых роботов эти законы не годятся. 1 вариант - оснастить своих бойцов особым чипом, имея который человек будет восприниматься роботом как "свой", робот по отношению к такому человеку с чипом будет действовать в соответствие с 3 законами. У кого такого чипа нет - следуя приказам или действуя автономно в зависимости от обстановки. Но контроль над роботом всегда должен быть. Должен сидеть оператор, отслеживающий действия, предположим, 10 роботов. Под рукой у него должны быть и кнопки аварийного отключения, и блокирующие оружие. Именно оператор и должен стараться исправить возможные ошибки робота. Что же касается чипа, то как предотвратить его попадание в руки врага или как сохранить в тайне его принцип действия, чтобы враг не смог скопировать - это вот задача потруднее, чем построить даже миллион боевых роботов. 2 вариант - "Терминаторы" - с самолёта над территорией врага сбрасывают автономных роботов на парашютах, которые активируются после появления, уничтожая вообще всех, кто оказывается в пределе их действия. При исчерпании боезапаса или по истечении определённого времени такие роботы самоуничтожаются, после чего на зачищенную территорию уже могут заходить другие войска. Но это план, скорее, для тотальной войны, когда стороне, применяющей таких роботов уже нечего терять. | ||

| 0 +0−0 | Александр Березин | 17:09:39 19/02/2015 | ||||||

| ||||||||

Это принципиально разные вещи. Из разных областей. | ||||||||

| 0 +1−1 | Александр Березин | 17:00:27 19/02/2015 | ||||||

| ||||||||

Роботам нужна именно этика, а не "свой-чужой". Потому что: а) "свой-чужой" при активной РЭБ вообще слабо работает, б) при различении мирного населения и боевиков ИГИЛ (или нынешнего ополчения на Донбассе) "свой-чужой" поможет как мертвому припарки. | ||||||||

| 0 +0−0 | Александр Березин | 16:54:46 19/02/2015 | ||||||

| ||||||||

"И проблему вычислимости надо решать не в бесконечном её варианте, а с ограничителем" Проблема исчислимости в принципе нерешама для машины Тьюринга. Какие бы вы ограничения не вводили на число шагов, максимум что удастся сделать -- предупредить фатальные сбои, однако решения проблемы (собственно расчёта будет ли останов) это дать не может. Это один из краугольных камней современной теории алгоритмов. Про ИИ сейчас вообще говорить рано, т.к. нет ни одной системы, которую можно было бы так назвать и высказываются серьзные сомнения в том, что сильный ИИ вообще может быть создан на базе алгоритмических машин. | ||||||||

| 0 +0−0 | Искин Люгер | 16:52:42 19/02/2015 | ||||||

| ||||||||

Ха ! Если бы так .... Если бы сделали проект равный Манхеттенскому, бороб с достаточным интеллектом появился бы лет за 5. А проблему робото-этики у нас раньше называли проблемой распознавания свой - чужой. | ||||||||